Par rapport aux élections de 2019, davantage de règles de plateforme européenne sont en place.

En juin prochain, quelque 365 millions de personnes auront le droit de voter aux élections européennes, parmi lesquelles de nombreux jeunes électeurs pour qui les réseaux sociaux constituent une ressource vitale pour faire campagne. Quatre pays – la Belgique, l’Allemagne, Malte et l’Autriche – permettront aux jeunes de 16 ans de voter ; en Grèce, l’âge minimum pour voter est de 17 ans.

Il y a cinq ans, lors du dernier vote européen, le paysage réglementaire des plateformes en ligne était très différent : il y avait moins de règles pour lutter contre la désinformation et la loi sur l’IA n’existait pas encore. Nous examinons comment la réglementation des plateformes dans l’UE a changé en 2024, par rapport aux dernières élections de 2019, et son impact sur les sociétés de médias sociaux.

1. Tik Tok

Les plateformes ont joué un rôle dans la campagne électorale de 2019, mais TikTok change véritablement la donne. Alors que Facebook et Twitter (maintenant X) étaient déjà importants il y a cinq ans, la plateforme chinoise de partage de vidéos TikTok a rapidement gagné en popularité et compte désormais plus de 150 millions d’utilisateurs mensuels à travers l’Europe. Meta dépasse encore ce chiffre avec quelque 408 millions d’utilisateurs mensuels en Europe.

Un rapport du Service de recherche du Parlement européen indique que le taux de participation électorale en 2019 a atteint 50,6 %, en grande partie grâce à la participation des jeunes, déclenchée par une campagne parlementaire et l’utilisation de plateformes comme Snapchat. TikTok, avec son grand nombre de jeunes utilisateurs, pourrait jouer un rôle tout aussi central cette fois-ci, malgré les turbulences réglementaires de la plateforme ces derniers mois.

La Commission européenne et le Parlement ont appelé le personnel à interdire l’application sur les téléphones professionnels en raison de craintes en matière de cybersécurité. Il est également « fortement recommandé » aux législateurs et à leurs assistants de supprimer TikTok de leurs appareils personnels. Certains groupes politiques, comme le groupe social-démocrate S&D et la Gauche (GUE/NGL), utilisent l’application pour leurs campagnes. Mais les craintes croissantes en matière de sécurité et de protection des données ces derniers jours concernant l’entreprise populaire ont mis la situation sous un jour différent. La Commission a lancé deux enquêtes de conformité liées à la protection des enfants en ligne dans le cadre du règlement européen sur les plateformes en février et avril.

2. Loi sur l’IA

L’Europe a été le premier continent à réglementer : sa loi sur l’IA tente d’imposer des règles strictes sur les systèmes d’apprentissage automatique à haut risque et ajoute des exigences de transparence pour les outils d’IA générative (GenAI) tels que ChatGPT. La loi sur l’IA devrait entrer en vigueur en juin, mais il sera trop tard pour avoir un impact sur les élections européennes.

Néanmoins, la prise de conscience des risques liés à ces outils s’est accrue. Les électeurs de l’UE sont de plus en plus préoccupés par l’impact de l’IA sur les processus démocratiques, comme sa capacité à accroître la diffusion de fausses informations et de contrefaçons, ce qui rend difficile la distinction entre le réel et l’illusoire, selon des enquêtes.

Afin de répondre à ces risques, des plateformes telles que Microsoft, Google et Meta se sont déjà engagées à empêcher l’ingérence de l’IA dans les élections dans le cadre d’un accord électoral présenté par l’IA au Conseil de sécurité de Munich en février dernier. « Alors que la société profite des avantages de l’IA, nous avons la responsabilité de veiller à ce que ces outils ne deviennent pas des armes lors des élections », a déclaré le vice-président et président de Microsoft, Brad Smith, lors de la signature.

Conformément aux lignes directrices de la Commission sur GenAI, les grandes plateformes en ligne devront par exemple utiliser des filigranes pour garantir aux utilisateurs que les informations relatives aux processus électoraux sont officielles. Meta a déclaré qu’il incluait déjà des filigranes visibles et invisibles pour les images créées avec sa plateforme GenAI.

3. DSA

En vertu de la loi sur les services numériques (DSA), proposée par la Commission européenne en 2020, les plateformes en ligne comptant plus de 45 millions d’utilisateurs mensuels moyens – dont Facebook et TikTok – sont tenues de prendre des mesures contre la désinformation et la manipulation électorale. Les règles ont commencé à s’appliquer à ces grandes entreprises technologiques depuis août de l’année dernière.

Les entreprises doivent également mettre en place des outils de modération de contenu, qui incluent la possibilité de contester les décisions lorsque le contenu des utilisateurs est supprimé ou restreint, ainsi qu’une transparence accrue pour les utilisateurs concernant les termes et conditions et la manière dont les algorithmes recommandent le contenu.

La vice-présidente de la Commission européenne, Margarethe Vestager, a déclaré que de nombreux débats électoraux se dérouleraient en ligne et que le DSA fournit des outils pour travailler ensemble avec les plateformes en ligne. « Nous pouvons faire face aux nouveaux risques en ligne pour les processus électoraux, comme les deep fakes. Nous pouvons ainsi permettre aux gens, en toute sécurité, de s’engager, de discuter et de prendre leur décision sans ingérence illégale », a-t-elle déclaré.

Afin de permettre aux entreprises de tester les règles, la Commission a récemment organisé (24 avril) un test de résistance sur les lignes directrices électorales du DSA.

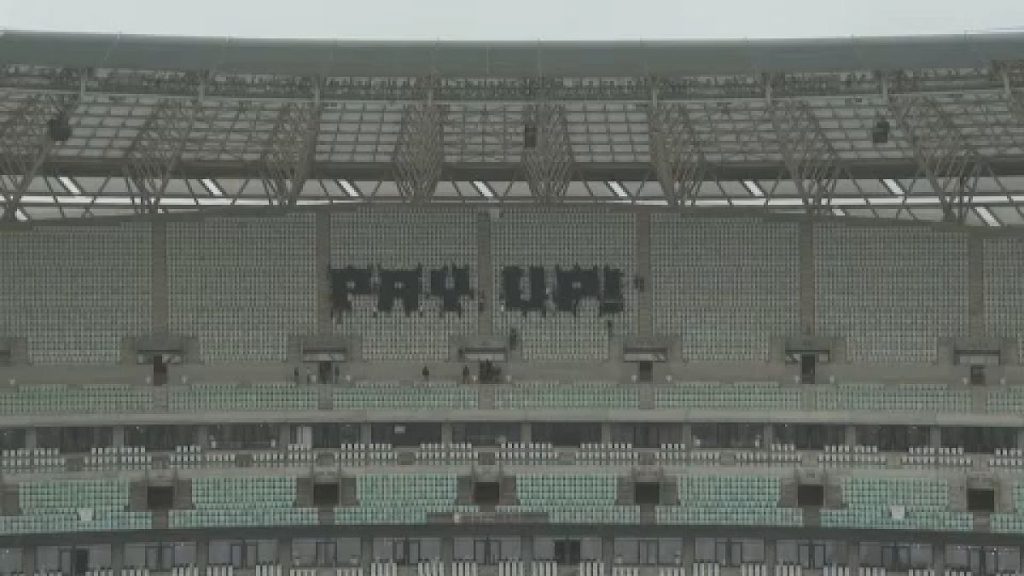

Les organisations à but non lucratif Mozilla et CheckFirst ont déclaré dans une étude publiée ce mois-ci (16 avril) que les plateformes en ligne ne fournissent pas suffisamment d’informations sur l’influence payante et les publicités commerciales avant les élections européennes de juin. Les groupes de la société civile s’interrogent également sur le manque de modérateurs de contenu pour certaines langues de l’UE comme le maltais, le néerlandais et l’estonien ; et donc la capacité des plateformes à réellement mettre un terme à la désinformation publiée dans ces pays. En outre, le DSA ne contient aucune information sur la manière dont les langues non officielles de l’UE sont modérées ni sur la manière dont le contenu, par exemple en russe ou en arabe, est modéré dans l’UE.

4. Publicité politique

Un autre changement réglementaire concerne les règles plus strictes affectant la publicité politique. En février dernier, le Parlement européen a approuvé des règles concernant ces publicités, visant à restreindre les ingérences étrangères, notamment en ligne. Dans le cadre de ce cadre, les sponsors de pays tiers ne pourront pas payer pour de la publicité politique dans l’UE dans les trois mois précédant une élection ou un référendum.

Les publicités politiques basées sur le profilage et l’utilisation de données de mineurs seront également interdites. De plus, toute publicité politique devra être clairement étiquetée comme telle et inclure des informations telles que qui a payé et combien elle a coûté.

Les plans ont été présentés par la Commission européenne en 2021 pour accroître la transparence de la publicité politique, dans le cadre de mesures visant à protéger l’intégrité des élections. Cependant, des groupes de la société civile, dont Access Now, s’inquiètent du fait que les règles soient arrivées trop tard pour protéger le prochain vote européen ; en outre, les informations telles que qui paie pour la publicité ne sont fournies que par auto-déclaration des groupes politiques.

«Bien que les mesures de transparence de la nouvelle loi empêchent la manipulation des électeurs et protègent les données personnelles des citoyens contre les abus dans les années à venir, elles n’auront pas beaucoup d’impact sur les élections européennes de 2024. Il s’agit donc d’une opportunité manquée, même si elle a un potentiel pour l’avenir. », indique un communiqué de presse.

De leur côté, les sociétés de médias sociaux TikTok et Meta ont annoncé ce mois-ci leurs mesures pour lutter contre la désinformation. Par exemple, Meta a déclaré qu’elle garantirait que les annonceurs qui diffusent des publicités liées aux élections avec elle devront divulguer s’ils utilisent l’IA ou de fausses images.