Nos gouvernements doivent être prêts à joindre le geste à la parole, en veillant à ce que les utilisations étatiques de l’IA soient soumises aux mêmes règles et exigences raisonnables que tout autre système d’IA, écrit Ella Jakubowska.

Les promesses visant à résoudre les plus grands problèmes de la société, ainsi que les allégations concernant le risque d’extinction de l’humanité, semblent être les sujets les plus brûlants de l’intelligence artificielle qui font la une des journaux.

Mais cette focalisation sur un avenir lointain promis détourne souvent l’attention des risques réels et présents.

L’un des problèmes que nous avons dangereusement négligés est que l’utilisation de systèmes d’IA va aggraver le déséquilibre de pouvoir déjà considérable entre les États et les peuples.

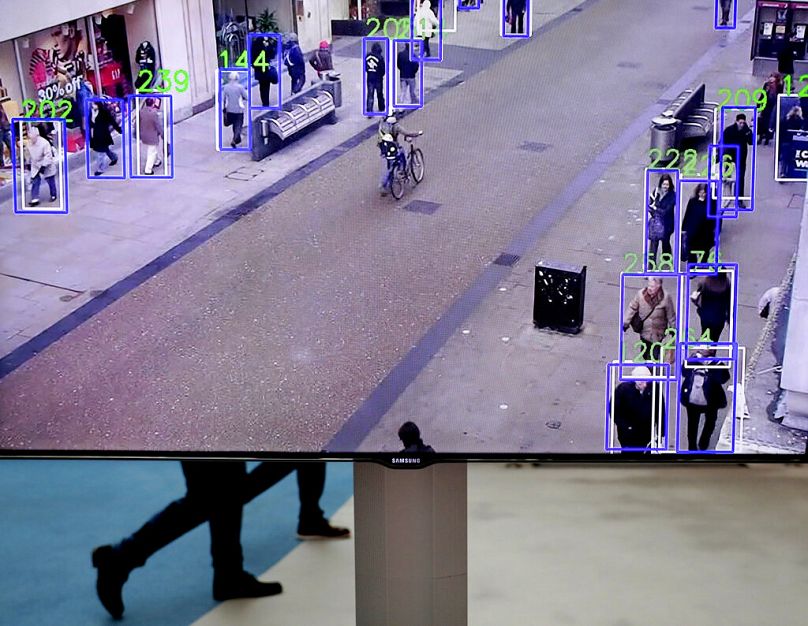

En tant que sujets de l’utilisation des technologies de l’IA par la police et d’autres autorités, cela devrait inquiéter chacun d’entre nous. L’utilisation croissante des systèmes d’IA dans les contextes de la police et des frontières, de la protection sociale et de l’éducation transforme l’administration publique et les espaces publics au-delà de toute reconnaissance.

Il est grand temps d’appliquer des règles procédurales et des garanties bien établies au contexte de l’IA. Les affirmations selon lesquelles la « surréglementation » « tuerait » l’innovation sont une fausse piste, détournant l’attention du fait que le contrôle déjà disproportionné des gouvernements – et des entreprises – sur nos vies sera renforcé si nous ne parvenons pas à appliquer les mêmes freins et contrepoids aux systèmes d’IA. nous le faisons dans tous les autres domaines de la vie.

Pourtant, les gouvernements de l’UE réagissent fermement, tentant de vider tout sens des tentatives législatives visant à protéger les citoyens contre les utilisations les plus nocives de l’IA.

La loi européenne sur l’intelligence artificielle touche à sa fin

Dans l’UE, la très attendue loi sur l’IA atteint sa phase finale de négociations. L’un des principes clés de ce projet de loi a toujours été que les individus et les sociétés doivent pouvoir « faire confiance » à l’utilisation des systèmes d’IA, en sachant notamment que les systèmes à risque sont correctement réglementés et que les systèmes extrêmement risqués sont interdits.

Les militants des droits civiques ont fait valoir que les pratiques invasives et manipulatrices telles que la reconnaissance faciale publique et la police prédictive doivent être totalement interdites. La surveillance biométrique massive des manifestations, des rues commerçantes, des parcs et autres espaces publics ne peut être acceptée dans une société libre.

Pourtant, les tentatives du Parlement européen visant à empêcher les gouvernements d’utiliser les systèmes d’IA de cette manière se heurtent à des obstacles de la part d’au moins vingt-six gouvernements des États membres de l’UE.

Ces États membres donnent la priorité aux objectifs de commodité, voire d’austérité, plutôt qu’aux freins et contrepoids appropriés qui nous protégeraient des dommages causés par des systèmes d’IA risqués.

L’argument sous-jacent des gouvernements de l’UE est que nous devons leur faire confiance pour utiliser ces systèmes de manière à garantir notre sécurité. Ils ont fait valoir que les interdictions sont un instrument trop brutal et que les garanties suffisent à prévenir les abus.

La confiance dans l’IA policière se mérite

Pourtant, lorsqu’il s’agit d’autres utilisations étatiques de l’IA, le récit ne pourrait pas être plus différent.

Les mêmes gouvernements qui nous demandent de leur faire confiance pour utiliser la reconnaissance faciale publique et la police prédictive de manière « sûre » sont les mêmes qui soutiennent qu’ils ne devraient pas avoir à suivre les règles de l’IA lorsqu’il s’agit des utilisations les plus dangereuses de l’IA par l’État – comme l’utilisation de l’IA par la police et les autorités chargées des migrations.

Ce sont précisément les cas où nous avons le plus besoin de transparence et de responsabilité. Les technologies numériques ne changent rien au fait que pour assurer la police par consentement, les États s’appuient sur la volonté et la confiance des personnes qu’ils gouvernent.

Mais comment pouvons-nous faire confiance à nos gouvernements pour qu’ils utilisent les systèmes d’IA en toute sécurité alors qu’ils refusent de suivre des règles qui nous protégeraient des dommages que cette technologie potentiellement dangereuse peut causer ?

Les États de l’UE ne gagneront pas la confiance des citoyens en gardant dans l’ombre leur utilisation des technologies d’IA, en rejetant les contrôles qui garantissent une conception sûre des systèmes, ni en autorisant des accords sans scrupules avec des sociétés d’IA avides de profits.

L’opacité et la technocratie de l’industrie de l’IA rendent encore plus important que jamais que le public ait un aperçu raisonnable de la manière dont nos gouvernements utilisent ces systèmes.

Sans cette transparence, nous risquons d’avoir des systèmes d’IA qui exacerbent les schémas discriminatoires et néfastes, piégeant les gens dans des boucles de fausses accusations et de procès algorithmiques.

Interdire les usages les plus dangereux

Malgré les affirmations bellicistes des responsables gouvernementaux et des fournisseurs de systèmes d’IA, les interdictions d’utilisations inacceptablement nocives des systèmes d’IA ne sont pas un instrument brutal.

En termes de droits de l’homme, nous parlons d’un éventail de garanties : depuis des garanties plus minimes pour des systèmes moins risqués, jusqu’à une interdiction totale lorsque nous savons que quelque chose n’est tout simplement pas compatible avec une société juste.

La réalité est que seul un très petit nombre de cas d’utilisation bien définis de l’IA sont sur la table pour une interdiction à l’échelle européenne dans la loi sur l’IA. Même dans ce cas, les États membres semblent disposés à faire des exceptions.

Prenez la reconnaissance faciale publique : selon le projet initial, seule l’utilisation de systèmes en « temps réel », « à distance », par la police et dans des « espaces accessibles au public » ferait l’objet d’une interdiction.

Retardez l’appariement d’une heure, faites-le dans un kiosque ou par une autorité administrative, ou tout autre nombre d’exceptions, et cela ne serait plus interdit.

Des groupes de la société civile ont toutefois fait valoir que la protection des droits à la vie privée, à la dignité, à la liberté d’expression et à l’égalité nécessite une interdiction totale de la surveillance de masse et des utilisations arbitraires des systèmes biométriques, ainsi que des contrôles stricts sur d’autres utilisations. Toutefois, les gouvernements de l’UE font pression pour des garanties si faibles qu’elles n’ont aucun sens.

Le problème de la double pensée

La double pensée des gouvernements européens sur ces questions trahit le manque de substance de leurs arguments.

Le récent décret américain sur l’IA, par exemple, a montré qu’il est effectivement possible d’inclure les agences chargées de l’application de la loi et de la sécurité nationale dans le champ d’application des règles sur l’IA.

Nos gouvernements doivent être prêts à joindre le geste à la parole, en veillant à ce que les utilisations étatiques de l’IA soient soumises aux mêmes règles et exigences raisonnables que tout autre système d’IA.

Et dans le petit nombre de cas où l’utilisation de l’IA s’est avérée tout simplement trop nocive pour être sécurisée, nous avons besoin d’interdictions.

Sans cela, nous ne pourrons pas croire que la loi européenne sur l’IA donne véritablement la priorité aux personnes et aux droits.