Les algorithmes reflètent la société qui les a créés, ce qui pose la logique selon laquelle, pour relever des défis spécifiques, la législation doit refléter la société, et pas seulement les algorithmes eux-mêmes, écrit Yonah Welker.

C’est quelques semaines seulement après que la déclaration de Bletchley a été signée par 28 pays qui se sont mis d’accord sur une approche basée sur les risques en matière d’IA aux frontières, de domaines, de types et de cas de risques, notamment la santé, l’éducation, le travail et les droits de l’homme.

Cela a été suivi par la publication par les États-Unis du premier décret sur l’IA, exigeant des évaluations de sécurité, des conseils en matière de droits civiques et des recherches sur l’impact sur le marché du travail, accompagné également du lancement de l’AI Safety Institute.

En parallèle, le Royaume-Uni a introduit l’AI Safety Institute et la loi sur la sécurité en ligne, faisant écho à l’approche de la loi sur l’Union européenne et les services numériques.

Malgré l’accord général, les pays en sont encore à différents stades de déploiement de cette vision, notamment la création d’entités de surveillance, les capacités requises, l’évaluation et l’infrastructure basées sur les risques, et la connexion des législations, directives et cadres existants.

Il existe également différentes approches pour mettre en œuvre cette surveillance, allant de l’approche plus stricte de l’UE – conduisant à l’opposition actuelle des développeurs de modèles fondateurs, notamment l’allemand Aleph Alpha et le français Mistral – à une approche plutôt « douce » au Royaume-Uni. .

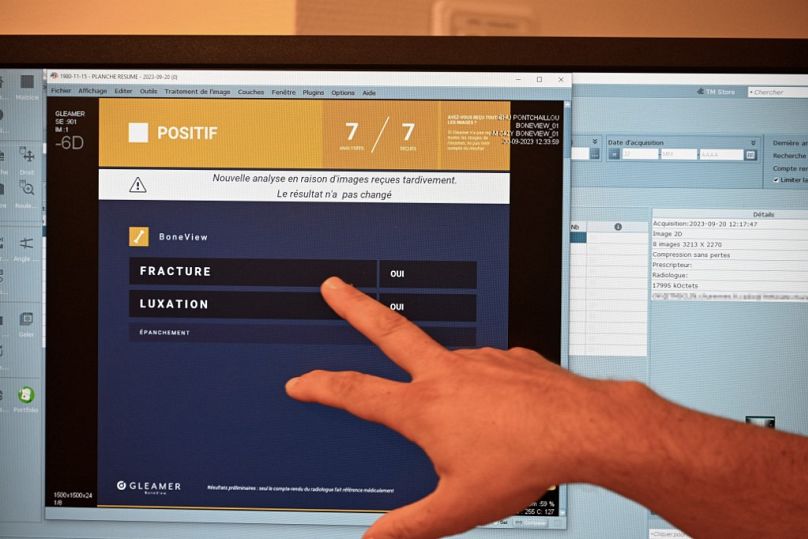

Il existe des questions encore plus importantes liées à des domaines spécifiques et à haut risque qui nécessitent plus d’attention, tels que les systèmes policiers, judiciaires et juridiques, la santé, l’éducation et les groupes désignés.

Ceci est particulièrement important pour des groupes tels que les personnes handicapées, les enfants et les populations vulnérables.

Une tâche complexe pour la politique et la technologie

Par exemple, on sait que de nombreux systèmes d’IA juridiques ont été formés sans la participation de populations spécifiques, ce qui entraîne un plus grand nombre d’erreurs à leur encontre. Dans certains pays, les agences gouvernementales ont été accusées d’utiliser les données des médias sociaux sans consentement pour confirmer le statut d’invalidité des patients dans le cadre des programmes de retraite.

Les immigrants ont tendance à éviter les examens et tests médicaux de peur d’être expulsés ou de devoir faire face à des frais médicaux inacceptables. Les statistiques et les ensembles de données publiques ne les reflètent tout simplement pas.

Enfin, l’IA peut ne pas identifier correctement les individus dépourvus de membres, présentant des différences faciales, une asymétrie, des troubles de la parole, des styles de communication ou des gesticulations différents, ou ceux qui utilisent des appareils et accessoires fonctionnels.

Dans un autre exemple, les systèmes de reconnaissance faciale peuvent utiliser la forme de l’oreille ou la présence d’un conduit auditif pour déterminer si une image comprend ou non un visage humain. Pourtant, cela peut ne pas fonctionner pour les groupes souffrant de syndromes cranio-faciaux ou dépourvus de ces parties.

Depuis la proposition initiale de l’EU AI Act en 2021, la Commission européenne a reçu des appels et des commentaires concernant l’IA et les droits des personnes handicapées, l’utilisation de systèmes de reconnaissance biométrique, faciale et émotionnelle, et les cas affectant les réfugiés et les immigrants, y compris l’évaluation automatisée des risques et le profilage. systèmes.

Cependant, la recherche et le développement de systèmes d’IA centrés sur le handicap restent une tâche complexe, tant d’un point de vue technologique que politique.

Il comprend sa nature intersectionnelle, sa condition, son âge, son sexe et ses paramètres spécifiques au spectre, ainsi que l’implication de multiples cadres juridiques pour le traiter et le protéger correctement.

Cela accroît le rôle des cadres non spécifiques à l’IA tels que la loi sur l’accessibilité, les lois de l’UE sur les services numériques et le marché, la Convention relative aux droits des personnes handicapées, les lois sur l’égalité et la protection des enfants, l’implication d’institutions spécialisées et d’agences multilatérales, venant ainsi au-delà de la simple formation d’« instituts de sécurité de l’IA » généralisés.

UE, IA, groupes désignés et écosystèmes juridiques

Il est important de se rappeler que la réglementation des systèmes d’IA s’adressant à des groupes désignés ou à des personnes handicapées ne se limite pas à un seul document juridique, mais plutôt à un éventail de cadres juridiques, de lois, de conventions et de politiques.

En particulier, de tels cas peuvent être réglementés ou affectés par des lois spécifiques à « l’IA », des données connexes, des cadres relatifs aux droits des consommateurs et de l’homme, des mémorandums et des conventions.

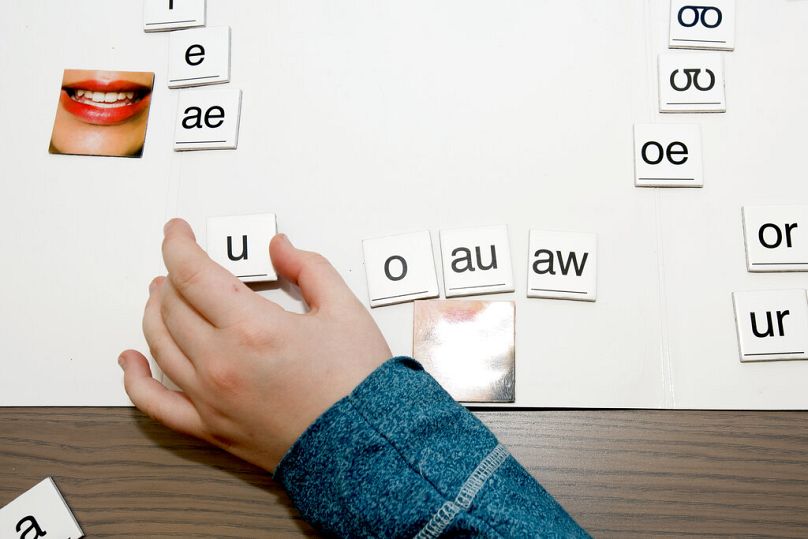

Par exemple, les technologies d’assistance utilisées pour soutenir la dyslexie ou l’autisme peuvent être affectées par les articles de la loi sur l’IA, la réglementation des données, les lois spécifiques protégeant les enfants et les groupes désignés telles que la Convention relative aux droits des personnes handicapées, et l’égalité et la non-représentation spécifiques à chaque pays. -les lois anti-discrimination.

La Commission européenne a commencé à explorer les moyens de lutter contre les systèmes d’IA et leurs risques spécifiques avant même que la loi sur l’IA ne soit pleinement introduite.

En particulier, le RGPD (Règlement général sur la protection des données) en vigueur présentait des articles relatifs au profilage des groupes désignés, à l’utilisation de données basées sur la « race » et le « genre », à la protection des mineurs, à la biométrie et aux systèmes et données de reconnaissance faciale.

Créer un espace numérique plus sûr

Du point de vue des groupes désignés, la Loi sur les services numériques joue également un rôle important (parallèle à la Loi sur le marché numérique).

Même s’il n’est pas spécifique à l’IA, il vise à « créer un espace numérique plus sûr où les droits fondamentaux des utilisateurs sont protégés ».

En particulier, il introduit des exigences en matière de transparence, de responsabilité, d’explicabilité des algorithmes utilisés, d’utilisation de « dark patterns », de protection des mineurs, de ciblage et de profilage, de confidentialité et de consentement, de manipulation, d’introduction de « signaleurs de confiance » et de modérateurs, la boucle de rétroaction entre les plateformes et les parties prenantes, désignées « coordinateurs des services numériques dans les États membres ».

Ces mécanismes contribuent à mieux aborder la protection des utilisateurs, la coopération entre États membres, les enquêtes et les cadres juridiques, y compris la participation des tribunaux et des autorités compétentes.

Il est accompagné de la loi sur l’accessibilité de 2025, visant à améliorer le fonctionnement du marché intérieur des produits et services accessibles, en supprimant les obstacles créés par les règles divergentes des États membres.

Enfin, ces efforts sont soutenus par des agences multilatérales, telles que l’UNESCO, l’OMS et l’OCDE, qui travaillent sur des lignes directrices spécifiques à un domaine pour aborder l’IA générative dans l’éducation, les soins de santé, l’alphabétisation et les recommandations axées sur les capacités.

Il comprend le cadre de compétences en IA de l’UNESCO pour les étudiants et les enseignants ou une recommandation visant à fixer l’âge minimum à 13 ans pour utiliser l’IA générative.

De plus, son récent plan d’action visant à lutter contre la désinformation et les méfaits des médias sociaux a recueilli des réponses de 134 pays, dont l’Afrique et l’Amérique latine.

Spécialisation, coopération et voie à suivre

Les algorithmes reflètent la société qui les a créés, ce qui pose la logique selon laquelle, pour relever des défis spécifiques, la législation doit refléter la société, et pas seulement les algorithmes.

L’atténuation des risques liés aux algorithmes envers les groupes désignés est un processus plutôt complexe, qui implique le rôle accru de la législation non spécifique à l’IA et va au-delà de la simple création d’« instituts de sécurité de l’IA ».

Cela comprend l’élaboration de catégories de risque et d’une évaluation d’impact spécifiques à ces groupes, la prise en compte des facteurs sociaux et historiques derrière les algorithmes, la garantie de l’accès aux données, ainsi que la surveillance et la participation multipartites.