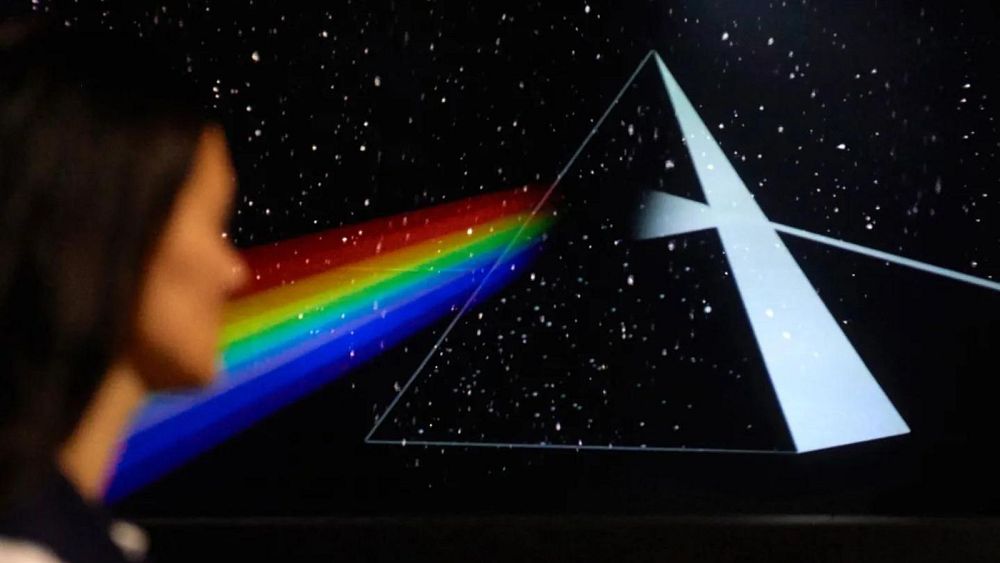

Les neuroscientifiques ont pu recréer « Another Brick in the Wall, Part 1 » en utilisant l’IA pour déchiffrer l’activité électrique du cerveau. La chanson reconstruite de Pink Floyd représente une percée qui pourrait restaurer la musicalité de la parole naturelle chez les patients souffrant de troubles neurologiques invalidants.

Les scientifiques ont reconstitué une chanson classique de Pink Floyd à partir des ondes cérébrales enregistrées de patients qui subissaient une chirurgie de l’épilepsie tout en écoutant la piste.

Des chercheurs de l’Université de Californie à Berkeley (États-Unis) ont utilisé des techniques d’intelligence artificielle pour décoder les signaux cérébraux, recréant le hit de 1979 « Another Brick In The Wall, Part 1 ».

L’équipe a déclaré que c’était la première fois que des scientifiques reconstituaient une chanson à partir d’enregistrements d’activité cérébrale.

Ce type de traduction algorithmique a été utilisé pour recréer la parole à partir de scanners cérébraux, mais pas de musique.

Pour l’étude, les chercheurs ont analysé les enregistrements d’activité cérébrale de 29 patients au Albany Medical Center dans l’État de New York de 2009 à 2015. Dans le cadre de leur traitement contre l’épilepsie, les patients avaient un réseau d’électrodes implantées dans leur cerveau. Cela a créé une rare opportunité pour les neuroscientifiques d’enregistrer leur activité cérébrale pendant qu’ils écoutaient de la musique. Au total, 2 668 électrodes ont été utilisées pour enregistrer toute l’activité cérébrale et 347 d’entre elles étaient spécifiquement liées à la musique.

Les scientifiques ont déclaré que la célèbre phrase « Dans l’ensemble, ce n’est qu’une autre brique dans le mur » est reconnaissable dans la chanson reconstruite et que les rythmes restent intacts.

« On dirait un peu qu’ils parlent sous l’eau, mais c’est notre première tentative », a déclaré Robert Knight, neurologue et professeur de psychologie à l’UC Berkeley à l’Institut Helen Wills Neuroscience qui a mené l’étude avec le boursier postdoctoral Ludovic Bellier.

Selon l’équipe, les résultats, rapportés dans la revue PLOS Biology, montrent que les signaux cérébraux peuvent être traduits pour capturer les éléments musicaux de la parole (prosodie) – modèles de rythme, de son, de stress et d’intonation – qui transmettent un sens que les mots seuls ne peuvent pas. exprimer.

Les scientifiques pensent que leurs travaux peuvent aider à comprendre comment le cerveau réagit à la musique et pourraient ouvrir la voie à de nouvelles prothèses qui peuvent aider à améliorer la perception du rythme et de la mélodie de la parole. Cette étude représente également une percée pour les neuroscientologues et les neurotechnologues qui souhaitent aider les personnes souffrant de lésions neurologiques graves – telles que la sclérose latérale amyotrophique, la maladie neurodégénérative dont Stephen Hawking a été diagnostiqué. Cela pourrait aider les personnes qui ont subi un accident vasculaire cérébral ou une paralysie, ou qui ont d’autres problèmes de communication verbale, à communiquer via des interfaces cerveau-ordinateur d’une manière qui semble plus naturelle.

« C’est un résultat merveilleux », a déclaré Knight.

« L’une des choses pour moi à propos de la musique, c’est qu’elle a un contenu prosodique et émotionnel. Au fur et à mesure que tout ce domaine des interfaces cerveau-machine progresse, cela vous donne un moyen d’ajouter de la musicalité aux futurs implants cérébraux pour les personnes qui en ont besoin, quelqu’un qui a la SLA ou un autre trouble neurologique ou du développement invalidant compromettant la sortie de la parole. Cela vous donne la capacité de décoder non seulement le contenu linguistique, mais une partie du contenu prosodique de la parole, une partie de l’affect. Je pense que c’est ce que nous avons vraiment commencé à déchiffrer. code activé. »