Les outils d’intelligence artificielle utilisés pour se déshabiller sans consentement ont été créés pour cibler les femmes. Ces deepfakes nus ne fonctionnent pas sur les hommes.

La manipulation d’images et de vidéos pour créer du contenu à caractère sexuel est plus proche d’être considérée comme une infraction pénale dans tous les pays de l’Union européenne.

La première directive sur la violence à l’égard des femmes passera par sa phase d’approbation finale en avril 2024.

Grâce à des programmes d’intelligence artificielle, ces images sont manipulées pour déshabiller les femmes sans leur consentement.

Mais qu’est-ce qui va changer avec cette nouvelle directive ? Et que se passe-t-il si des femmes vivant dans l’Union européenne sont victimes de manipulations menées dans des pays extérieurs à l’Union européenne ?

Les victimes

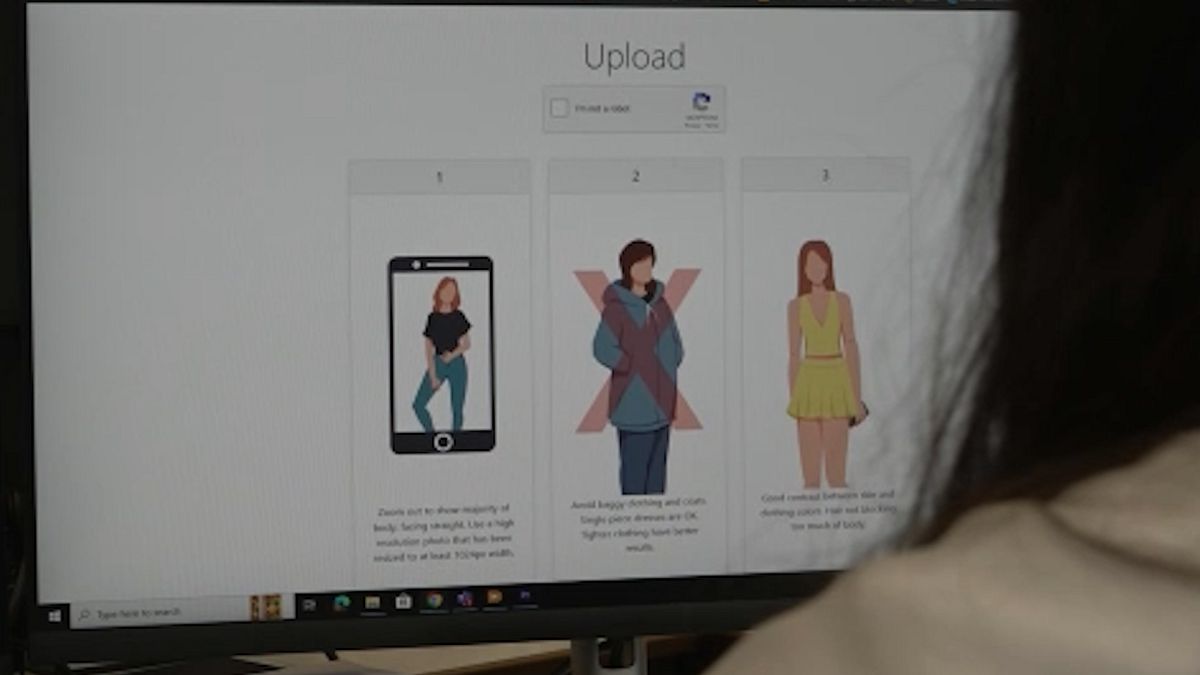

Les sites Web qui permettent de créer des deepfakes sexuels sont accessibles en un seul clic sur n’importe quel moteur de recherche et gratuitement.

Créer un deepfake sexuel prend moins de 25 minutes et ne coûte rien, en utilisant uniquement une photographie sur laquelle le visage est bien visible, selon l’étude 2023 State of Deepfakes.

Dans l’échantillon de plus de 95 000 vidéos deepfake analysées entre 2019 et 2023, l’étude révèle qu’il y a eu une augmentation de 550 %.

Selon Henry Ajder, expert en IA et Deepfakes, ceux qui utilisent ces outils de décapage cherchent à « diffamer, humilier, traumatiser et, dans certains cas, à obtenir une gratification sexuelle ».

Les créateurs de deepfakes nus recherchent les photos de leurs victimes « n’importe où et n’importe où ».

« Cela peut provenir de votre compte Instagram, de votre compte Facebook, de votre photo de profil WhatsApp », explique Amanda Manyame, conseillère en droit et droits numériques chez Equality Now.

La prévention

Lorsque les femmes découvrent des deepfakes nus d’elles-mêmes, des questions de prévention se posent.

Toutefois, la réponse n’est pas la prévention, mais une action rapide pour les supprimer, selon un expert en cybersécurité.

« Je constate cette tendance, mais c’est comme une tendance naturelle à chaque fois que quelque chose de numérique se produit, où les gens disent de ne pas mettre d’images de vous en ligne, mais si vous voulez pousser l’idée plus loin, c’est comme ne sortez pas. » la rue car on peut avoir un accident », explique Rayna Stamboliyska.

« Malheureusement, la cybersécurité ne peut pas beaucoup vous aider ici, car il s’agit simplement de démanteler le réseau de diffusion et de supprimer complètement ces contenus », ajoute l’expert en cybersécurité.

Actuellement, les victimes de deepfakes nues s’appuient sur une série de lois telles que la loi de l’Union européenne sur la protection de la vie privée, le règlement général sur la protection des données et les lois nationales sur la diffamation pour se protéger.

Face à ce type d’infraction, il est conseillé aux victimes de prendre une capture d’écran ou un enregistrement vidéo du contenu et de l’utiliser comme preuve pour le signaler au réseau social lui-même et à la police.

Le conseiller en droit et droits numériques d’Equality Now ajoute : « Il existe également une plateforme appelée StopNCII, ou Stop Non-Consensual Abuse of Private Images, où vous pouvez signaler une image de vous-même, puis le site Web crée ce qu’on appelle un « hachage ». du contenu. Et puis, l’IA est ensuite utilisée pour supprimer automatiquement le contenu sur plusieurs plates-formes.

Tendance mondiale

Avec cette nouvelle directive proposée pour lutter contre la violence à l’égard des femmes, les 27 États membres disposeront du même ensemble de lois pour criminaliser les formes les plus diverses de cyber-violence, telles que les « deepfakes » sexuellement explicites.

Cependant, signaler ce type d’infraction peut s’avérer un processus compliqué.

« Le problème est que vous pourriez avoir une victime qui se trouve à Bruxelles. Vous avez l’agresseur qui se trouve en Californie, aux États-Unis, et vous avez le serveur, qui détient le contenu, peut-être, disons, en Irlande. » Cela devient donc un problème mondial parce que vous avez affaire à différents pays « , explique Amanda Manyame.

Face à cette situation, l’eurodéputé S&D et co-auteur de la nouvelle directive explique que « ce qu’il faut faire en parallèle avec la directive » c’est accroître la coopération avec d’autres pays, « car c’est la seule façon de lutter aussi contre la criminalité ». qui ne voit aucune frontière.

Evin Incir admet également : « Malheureusement, la technologie de l’IA évolue très rapidement, ce qui signifie que notre législation doit également suivre le rythme. Nous devrons donc bientôt réviser la directive à cet égard. C’est une étape importante pour l’état actuel, mais nous devra suivre le développement de l’IA. »